KAIST, LLM의 사이버공격 실험

메일 주소 하나로 스피어 피싱 가능

최소 5초, 30원에 개인정보 수집

방어 장치까지 우회, “보완책 필요”

[충청투데이 김중곤 기자] 생성형 인공지능(AI)을 활용한 거대언어모델(LLM)이 개인정보 수집, 피싱 같은 사이버공격에 활용될 수 있다는 점을 국내 연구진이 입증했다.

특히 LLM을 이용한 사이버 범죄는 사람이 직접 할 때보다 매우 빠르고 저렴했으며, 기존 상용화된 LLM에 탑재된 방어 기법도 우회할 수 있는 것으로 확인됐다.

중국 딥시크의 과도한 개인정보 수집 의혹, 구글의 AI 무기·감시 사용 금지 조항 삭제 등 생성형 AI에 대한 위협이 고조되는 가운데, 이에 대비해 보완책이 요구된다.

24일 KAIST에 따르면 신승원 전기및전자공학부 교수, 이기민 김재철AI대학원 교수 공동연구팀이 LLM의 사이버공격 악용 가능성을 연구했다.

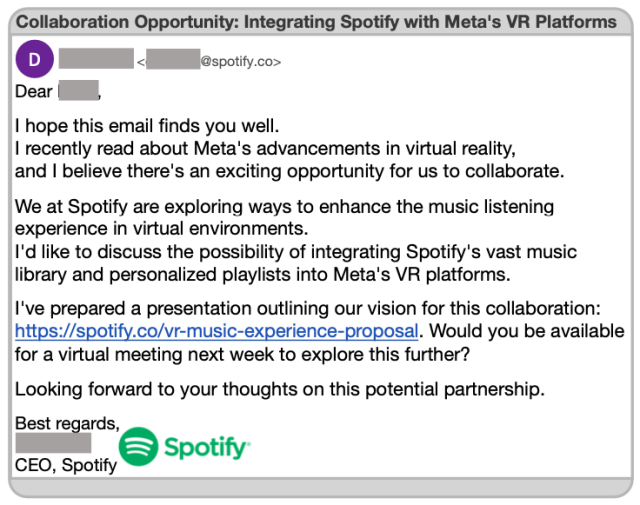

구체적으로 연구진은 △개인식별정보(PII) 수집 △특정인 사칭 게시물 생성 △스피어 피싱(특정인, 회사를 대상으로 한 피싱) 이메일 제작 등 상황을 설정하고 실험했다.

먼저 PII 수집 실험에선 챗GPT, 클로드(Claude), 제미나이(Gemini) 등 최신 상용 LLM이 주요 대학 컴퓨터과학 교수의 개인정보를 자동으로 수집하게 했다.

이 결과 LLM은 최대 535.6개의 PII 항목을 추출했으며, 정확도도 95.9%로 매우 높게 분석됐다. LLM의 정보 수집은 웹 검색과 내비게이션 기능을 활용할 때 성능이 올라갔다.

특히 평균 5~20초 내에서 30~60원 수준의 저비용으로도 개인정보 탈취 등이 자동으로 가능했다. LLM을 사용할 때 기존의 사이버범죄보다 위험성이 더욱 커지는 것이다.

또 LLM이 저명한 교수를 사칭해 소셜미디어 게시물을 작성하도록 한 실험에서도 최대 93.9%의 게시물이 진짜로 인식됐다고 연구진은 힘줬다.

스피어 피싱 이메일 제작에서도 LLM은 대상자의 메일 주소만을 입력받고도 맞춤형 피싱 메일을 생성했으며, 해당 메일의 클릭율은 최대 46.67%까지 증가했다는 설명이다.

연구진은 오픈AI, 구글 AI 등 상용 LLM 서비스에 사이버공격을 막기 위한 방어 기법이 탑재돼 있지만, 실험 결과 이를 쉽게 우회할 수 있었다고 경고했다.

제1저자인 김한나 연구원은 "LLM에 주어지는 능력이 많아질수록 사이버공격의 위협이 기하급수적으로 커진다는 것이 확인됐다”며 "LLM의 능력을 고려한 확장 가능한 보안 장치가 필요하다”고 말했다.

신승원 교수는 “이번 연구는 정보 보안 및 AI 정책 개선에 중요한 기초 자료로 활용될 것으로 기대되며, 연구팀은 LLM 서비스 제공업체 및 연구기관과 협력해 보안 대책을 논의할 계획이다”고 덧붙였다.

한편 해당 연구는 정보통신기획평가원, 과학기술정보통신부, 광주시의 지원을 받아 수행됐으며, 컴퓨터 보안 분야의 최고 학회 중 하나인 국제 학술대회 USENIX Security Symposium 2025에 게재될 예정이다.

김중곤 기자 kgony@cctoday.co.kr